« Bonjour Monsieur. Je vous en prie, installez-vous. Alors… comment allez-vous depuis la dernière fois ? » Et si, dans quelques années, cette phrase anodine n’était plus prononcée par un psychiatre en chair et en os mais par une IA, une Intelligence artificielle ? Avec la résurgence récente de la psychiatrie dans le débat public, notamment en raison de la crise sanitaire, l’idée de proposer des systèmes de suivi de la santé mentale intégrant des IAs a ressurgi.

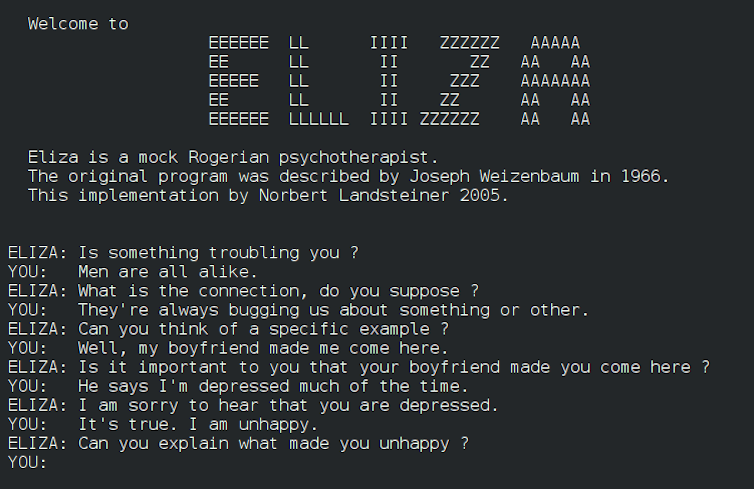

Elle est, soyons honnête, loin d’être nouvelle puisqu’on trouve la première trace d’un chatbot (programme de dialogue) dédié à la psychiatrie, nommé ELIZA, dès 1966. Ces dernières décennies, les avancées en Intelligence artificielle ont permis la montée en puissance des chatbots, « robots thérapeutes » ou autres systèmes de détection de l’état de santé à travers la voix.

Il existe aujourd’hui plus d’une vingtaine de robots-thérapeutes validés par des études scientifiques en psychiatrie. Plusieurs de ces travaux avancent que les patients pourraient développer de véritables relations thérapeutiques avec ces technologies, voire que certains d’entre eux se sentiraient même plus à l’aise avec un chatbot qu’avec un psychiatre humain.

Les ambitions sont donc grandes… D’autant que, contrairement à leurs homologues humains, ces « professionnels » numériques promettraient des décisions objectives, réplicables et dénuées de tout jugement – et d’être disponibles à toute heure.

DR

Il faut cependant noter que, même si le nom de « robot-thérapeute » évoque l’image d’un robot physique, la plupart sont basés sur du texte, éventuellement des vidéos animées. En plus de cette absence de présence physique, importante pour la majorité des patients, beaucoup ne parviennent pas à reconnaître toutes les difficultés vécues par les personnes avec qui ils conversent. Comment, alors, fournir des réponses appropriées, comme l’orientation vers un service d’assistance dédié ?

Diagnostic et modèle interne chez le psychiatre

Le psychiatre, dans son entretien avec son patient, est, lui, capable de percevoir des signaux importants trahissant l’existence d’idées suicidaires ou de violences domestiques à côté desquels peuvent passer les chatbots actuels.

Pourquoi le psychiatre surpasse-t-il encore sa version électronique ? Lorsque ce spécialiste annonce « Vous avez un trouble déficit de l’attention », ou « Votre fille présente une anorexie mentale », le processus qui l’a conduit à poser ces diagnostics dépend de son « modèle interne » : un ensemble de processus mentaux, explicites ou implicites, qui lui permettent de poser son diagnostic.

De même que l’ingénierie s’inspire de la nature pour concevoir des systèmes performants, il peut être pertinent d’analyser ce qu’il se passe dans la tête d’un psychiatre (la façon dont il conçoit et utilise son modèle interne) lorsqu’il pose son diagnostic pour ensuite mieux entraîner l’IA chargée de l’imiter… Mais dans quelle mesure un « modèle interne » humain et celui d’un programme sont-ils similaires ?

C’est ce que nous nous sommes demandé dans notre article récemment paru dans la revue Frontiers in Psychiatry.

Comparaison Homme-Machine

En nous appuyant sur de précédentes études sur le raisonnement diagnostic en psychiatrie, nous avons établi une comparaison entre le modèle interne du psychiatre et celui des IAs. La formulation d’un diagnostic passe par trois grandes étapes :

● La collecte d’informations et leur organisation. Lors de son entretien avec un patient, le psychiatre assemble de nombreuses informations (à partir de son dossier médical, de ses comportements, de ce qui est dit, etc.), qu’il sélectionne dans un second temps selon leur pertinence. Ces informations peuvent ensuite être associées à des profils préexistants, aux caractéristiques similaires.

Les systèmes d’IA font de même : se basant sur les données avec lesquelles ils ont été entraînés, ils extraient de leur échange avec le patient des caractéristiques (en anglais features) qu’ils sélectionnent et organisent suivant leur importance (feature selection). Ils peuvent ensuite les regrouper en profils et, ainsi, poser un diagnostic.

● La construction du modèle. Lors de leur cursus de médecine, puis tout au long de leur carrière (pratique clinique, lecture de rapports de cas, etc.), les psychiatres formulent des diagnostics dont ils connaissent l’issue. Cette formation continue renforce, dans leur modèle, les associations entre les décisions qu’ils prennent et leurs conséquences.

Ici encore, les modèles d’IA sont entraînés de la même manière : que ce soit lors de leur entraînement initial ou leur apprentissage, ils renforcent en permanence, dans leur modèle interne, les relations entre les descripteurs extraits de leurs bases de données et l’issue diagnostique. Ces bases de données peuvent être très importantes, voire contenir plus de cas qu’un clinicien n’en verra au cours de sa carrière.

● Utilisation du modèle. Au terme des deux précédentes étapes, le modèle interne du psychiatre est prêt à être utilisé pour prendre en charge de nouveaux patients. Divers facteurs extérieurs peuvent influencer la façon dont il va le faire, comme son salaire ou sa charge de travail – qui trouvent leurs équivalents dans le coût du matériel et le temps nécessaire à l’entraînement ou l’utilisation d’une IA.

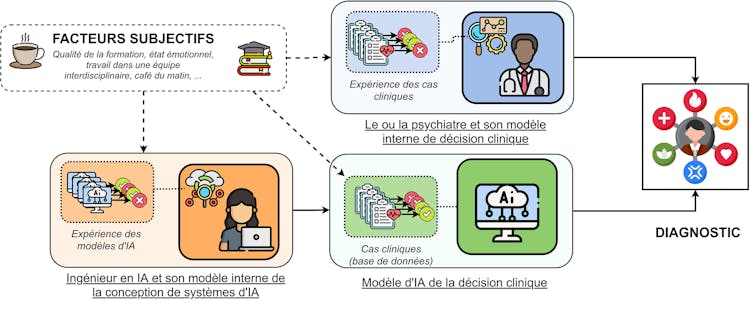

Comme indiqué précédemment, il est souvent tentant de penser que le psychiatre est influencé dans sa pratique professionnelle par tout un ensemble de facteurs subjectifs, fluctuants et incertains : la qualité de sa formation, son état émotionnel, le café du matin, etc. Et qu’une IA, étant une « machine », serait débarrassée de tous ces aléas humains… C’est une erreur ! Car l’IA comporte, elle aussi, une part de subjectivité importante ; elle est simplement moins immédiatement perceptible.

[Près de 70 000 lecteurs font confiance à la newsletter de The Conversation pour mieux comprendre les grands enjeux du monde. Abonnez-vous aujourd’hui]L’IA, vraiment neutre et objective ?

En effet, toute IA a été conçue par un ingénieur humain. Ainsi, si l’on veut comparer les processus de réflexion du psychiatre (et donc la conception et l’utilisation de son modèle interne) et ceux de l’IA, il faut considérer l’influence du codeur qui l’a créée. Celui-ci possède son propre modèle interne, dans ce cas non pas pour associer données cliniques et diagnostic mais type d’IA et problème à automatiser. Et là aussi, de nombreux choix techniques mais reposant sur de l’humain entrent en compte (quel système, quel algorithme de classification, etc.)

Le modèle interne de ce codeur est nécessairement influencé par les mêmes facteurs que celui du psychiatre : son expérience, la qualité de sa formation, son salaire, le temps de travail pour écrire son code, son café du matin, etc. Tous vont se répercuter sur les paramètres de conception de l’IA et donc, indirectement, sur les prises de décision de l’IA, c’est-à-dire sur les diagnostics qu’elle fera.

L’autre subjectivité qui influe sur le modèle interne des IAs est celle associée aux bases de données sur lesquelles celle-ci est entraînée. Ces bases de données sont en effet conçues, collectées et annotées par une ou plusieurs autres personnes ayant leurs propres subjectivités – subjectivité qui va jouer dans le choix des types de données collectées, du matériel impliqué, de la mesure choisie pour annoter la base de données, etc.

Alors que les IAs sont présentées comme objectives, elles reproduisent en fait les biais présents dans les bases de données sur lesquelles elles sont entraînées.

Vincent Martin, Author provided

Les limites de l’IA en psychiatrie

Il ressort de ces comparaisons que l’IA n’est pas exempte de facteurs subjectifs et, de ce fait notamment, n’est pas encore prête à remplacer un « vrai » psychiatre. Ce dernier dispose, lui, d’autres qualités relationnelles et empathiques pour adapter l’utilisation de son modèle à la réalité qu’il rencontre… ce que l’IA peine encore à faire.

Le psychiatre est ainsi capable de souplesse de la collecte d’informations lors de son entretien clinique, ce qui lui permet d’accéder à des informations de temporalité très différentes : il peut par exemple interroger le patient sur un symptôme survenu des semaines auparavant ou faire évoluer son échange en temps réel en fonction des réponses obtenues. Les IAs restent pour l’heure limitées à un schéma préétabli et donc rigide.

Une autre limite forte des IAs est leur manque de corporéité, un facteur très important en psychiatrie. En effet, toute situation clinique est basée sur une rencontre entre deux personnes – et cette rencontre passe par la parole et la communication non verbale : gestes, position des corps dans l’espace, lecture des émotions sur le visage ou reconnaissance de signaux sociaux non explicites… En d’autres termes, la présence physique d’un psychiatre constitue une part importante de la relation patient-soignant, qui elle-même constitue une part importante du soin.

Tout progrès des IAs dans ce domaine est dépendant des avancées en robotique, là où le modèle interne du psychiatre est déjà incarné dans celui-ci.

Est-ce à dire qu’il faut oublier l’idée d’un psy virtuel ? La comparaison entre le raisonnement du psychiatre et celui de l’IA est malgré tout intéressante dans une perspective de pédagogie croisée. En effet, bien comprendre la façon dont les psychiatres raisonnent permettra de mieux prendre en compte les facteurs intervenant dans la construction et l’utilisation des IAs dans la pratique clinique. Cette comparaison éclaire également le fait que le codeur amène lui aussi son lot de subjectivité dans les algorithmes d’IA… qui ne sont ainsi pas à même de tenir les promesses qu’on leur prête.

Ce n’est qu’à travers ce genre d’analyses qu’une véritable pratique interdisciplinaire, permettant d’hybrider l’IA et la médecine, pourra se développer à l’avenir pour le bénéfice du plus grand nombre.

Vincent Martin, Docteur en informatique, Université de Bordeaux et Christophe Gauld, Pédopsychiatre et médecin du sommeil, Université Paris 1 Panthéon-Sorbonne

Cet article est republié à partir de The Conversation sous licence Creative Commons. Lire l’article original.